Page 35 - 金融科技视界2023-1期

P. 35

Technical Tracking

技术追踪

可以像人类使用Wolfram|Alpha一样,与Wolfram|Alpha“对

话”,Wolfram|Alpha则会用其符号翻译能力将从ChatGPT获

得的自然语言表达“翻译”为对应的符号化计算语言。在过去,

学术界在ChatGPT使用的这类“统计方法”和Wolfram|Alpha

的“符 号方 法”上一直存 在 路线 分歧。但 如今 C h at G P T 和

三类模型压缩:

Wolfram|Alpha的互补,给NLP领域提供了更上一层楼的可能。

第一种方法是量化

ChatGPT不必生成这样的代码,只需生成常规自然语言,然

第二种模型压缩方法是剪枝

后使用Wolfram|Alpha翻译成精确的Wolfram Language,再

由底层的Mathematica进行计算。 第三种模型压缩方法是稀疏化

5.3 ChatGPT的小型化

虽然ChatGPT很强大,但其模型大小和使用成本也让很多

人望而却步。 练。对GPT-175B模型,只需要使用

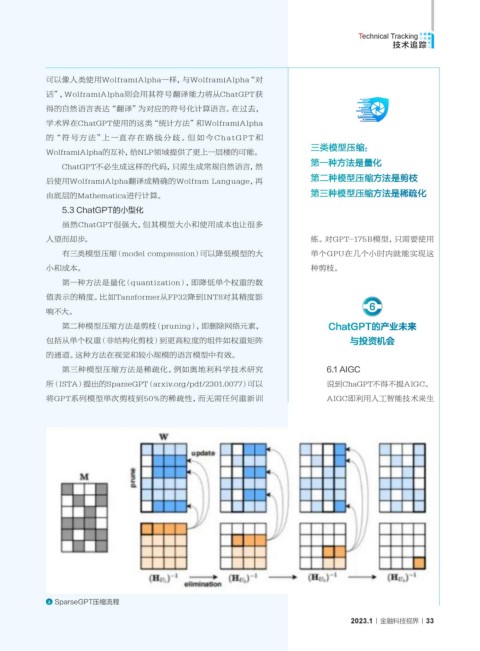

有三类模型压缩(model compression)可以降低模型的大 单个GPU在几个小时内就能实现这

小和成本。 种剪枝。

第一种方法是量化(quantization),即降低单个权重的数

值表示的精度。比如Tansformer从FP32降到INT8对其精度影

6

响不大。

第二种模型压缩方法是剪枝(pruning),即删除网络元素, ChatGPT的产业未来

包括从单个权重(非结构化剪枝)到更高粒度的组件如权重矩阵 与投资机会

的通道。这种方法在视觉和较小规模的语言模型中有效。

第三种模型压缩方法是稀疏化。例如奥地利科学技术研究 6.1 AIGC

所(ISTA)提出的SparseGPT(arxiv.org/pdf/2301.0077)可以 说到ChaGPT不得不提AIGC。

将GPT系列模型单次剪枝到50%的稀疏性,而无需任何重新训 AIGC即利用人工智能技术来生

SparseGPT压缩流程

2023.1 金融科技视界 33